通信世界网消息(CWW)随着ChatGPT的发布,各行各业开启探索、应用人工智能大模型的新时代。在海量数据、大规模算力和强大的算法优化能力等条件的支撑下,基于深度学习等技术的庞大神经网络模型问世,使自然语言处理、语音识别、计算机视觉等任务的处理得到了极大的改善。

由于人类生活在包含文本、图片、音频、视频等不同模态数据的世界里,利用大模型对不同模态数据进行跨模态的统一表征学习是一种更为接近人类的学习模式。这种多模态大模型必然成为未来发展的重要方向。

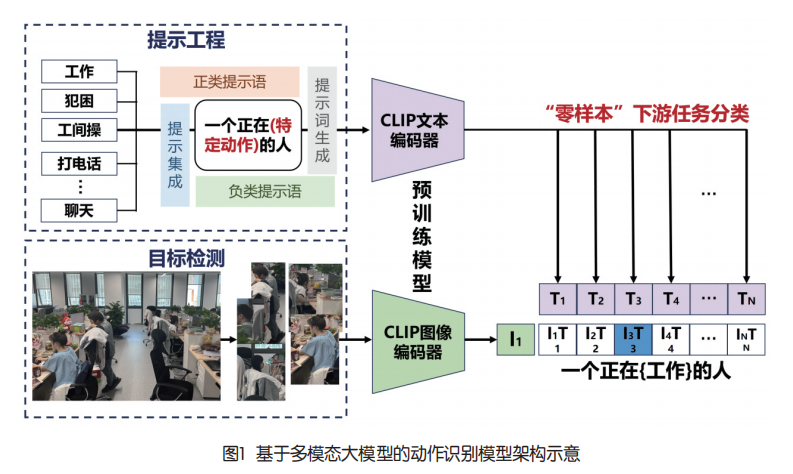

为将多模态大模型有效应用于动作识别任务中,中国移动信息技术中心智能AI研发团队采用基于预训练的CLIP多模态大模型,结合目标检测与提示工程技术,实现“零样本”条件下的动作识别。目前,该模型已应用在各类动作识别任务中,取得了理想的效果,超越了传统的人工智能算法。

多模型大模型解决动作识别痛点问题

动作识别是一类典型的分类任务,采用传统深度学习模型进行动作识别主要存在分类类别受限、无法实现“零样本”分类的痛点。这意味着当下游场景存在新动作类别时,模型需要重新训练,无法直接部署应用。此外,当数据场景复杂或数据量不足时,传统深度学习模型的动作识别性能会显著下降;而多模态大模型的多模态统一表征能力为分类任务提供了新的“范式”,即可通过确定任意类别文本提示语,并计算类别提示语与分类目标相似度的方式,实现目标的分类,分类类别不再受训练集的约束。多模态大模型所带来的分类新“范式”可有效规避上述传统深度学习模型的缺点,为动作识别开辟了一条新的路径。基于多模态大模型的动作识别模型架构如图1所示。

CLIP模型实现多模态特征的对齐

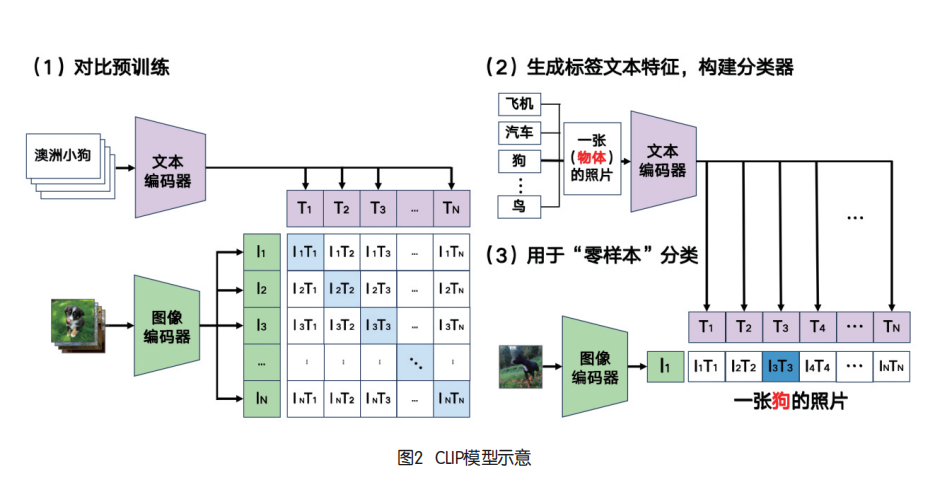

多模态大模型必须具备多模态信息的综合处理与分析能力,因而需要一个将多模态特征进行联通的“桥梁”。2021年,OpenAI提出了CLIP系列多模态大模型,实现了文本与图像多模态特征的对齐:将文本与图像的多模态特征转换到同一特征空间进行表示。CLIP模型如图2所示。

CLIP模型由一个文本编码器与一个图像编码器组成,其训练过程使用了超过4亿的“图像—文本”对数据集,采用了对比学习策略,以自然语言作为监督信号训练视觉模型,使其生成的图像与文本特征均具有多模态特性。

CLIP模型可以通过“零样本”或少样本的形式直接用于下游任务,并获得良好的性能。确定类别提示语后,可让CLIP模型对提示语进行分类,做到“无限细粒度”的标签分类,不再受训练集样本类别的限制。

因此,研发团队采用了CLIP模型作为动作识别任务的基础模型架构,已在打电话、工作状态(认真工作、犯困)等多项业务场景中使用。

目标检测算法降低大模型分析难度

虽然CLIP多模态大模型打破了分类类别限制,拥有极强的“零样本”下游任务泛化能力,但是其仍然缺乏细粒度精确分析的能力。因此,通常需要结合目标检测算法,用于在动作识别之前提前检测出动作识别的具体目标——人体。目标检测算法的使用可缩小CLIP模型的图像特征提取范围,排除干扰信息,显著增加模型的鲁棒性。

在实际构建过程中,研发团队选择了基于Yolo v8的目标检测算法实现人体目标的识别。由于视频监控场景下大多数监控器位于房间的角落,对于拍摄到的人体具有远近的显著特征差距,会导致目标检测算法性能的下降。针对上述问题,研发团队提出了自适应检测框尺度变换算法,针对不同的远近距离,自动对检测框进行长宽尺度的变化,保证人体及其周围适当背景像素信息的保留。

提示工程显著增强大模型分类能力

与语言大模型类似,提示工程在基于多模态大模型的判别任务中举足轻重。因此,在动作识别任务中,需要针对特定业务场景设计合适的类别提示语,从而让大模型根据提示语区分不同类别的动作,合适的提示语将极大增强大模型的分类能力。研发团队在特征工程上提出了一种基于多模态大模型提示词生成与提示语集成的新方法。

为了实现基于CLIP模型的动作识别,需要构建正类与负类提示语列表。具体而言,正类提示语列表包含多个正类提示语,每个提示语均可描述需要找出的动作类别;负类提示语列表中包含多个负类提示语,每个负类提示语列表中的负类提示语均描述同一种负类动作。

为了生成正类提示语,研发团队采用基于多模态大模型BLIP的生成策略。BLIP是一种图生文大模型,它可以根据图像生成对应的自然语言描述。通过对一类动作的图像数据集使用BLIP模型生成描述,并进行相关词语筛选与词频统计,可获得针对对应动作的高频描述提示词,这类词语可作为正类提示语的组成部分。负类提示词则根据实际场景,采用需要和正类区分的动作类别词语作为提示词。最后,通过将每个正类提示词与负类提示词套用提示语模板(如:“一个人正在{打电话}的图像”,其中{·}为提示词),生成若干正类与负类的完整提示语,进而形成正类与负类提示语列表。

在获得提示语列表后,采用提示集成策略,计算正类提示语和每个同类负类提示语的平均文本特征;进一步将平均文本特征标准化,可获得针对每类动作的最终类别提示语特征。在实际使用过程中,选择CLIP模型认为与图像特征相似度最高的提示语特征所表示的动作类别作为最终的分类结果。提示集成策略在基于单个个体的动作识别任务中可获得良好的效果,如打电话、工作状态识别等场景。

总结与展望

大模型时代的到来为动作识别提供了新的方法。中国移动信息技术中心积极探索多模态大模型在视频理解领域的应用,将相关能力上架至中国移动能力中台,在阳光评标、智慧乡村、智慧园区等产品项目中落地实践,获得了良好的用户反响。相比OpenPose+规则的动作识别方法,在工作状态识别任务上,多模态大模型可获得超过50%综合准确率提升;在打电话动作识别任务上,多模态大模型可在50%召回率的情况下,提升接近70%的精确度。然而,大模型仍然存在参数量大的局限性,多模态大模型的使用将大大增加模型训练与推理的时间成本,也大大提升部署模型所需要的硬件设备条件,从而限制模型在边缘端设备上的使用。针对上述缺陷,未来中国移动信息技术中心将致力于研发适合于多模态大模型的模型压缩与推理加速技术,进一步推动多模态大模型的落地应用。示语,每个提示语均可描述需要找出的动作类别;负类提示语列表中包含多个负类提示语,每个负类提示语列表中的负类提示语均描述同一种负类动作。为了生成正类提示语,研发团队采用基于多模态大模型BLIP的生成策略。BLIP是一种图生文大模型,它可以根据图像生成对应的自然语言描述。通过对一类动作的图像数据集使用BLIP模型生成描述,并进行相关词语筛选与词频统计,可获得针对对应动作的高频描述提示词,这类词语可作为正类提示语的组成部分。负类提示词则根据实际场景,采用需要和正类区分的动作类别词语作为提示词。最后,通过将每个正类提示词与负类提示词套用提示语模板(如:“一个人正在{打电话}的图像”,其中{·}为提示词),生成若干正类与负类的完整提示语,进而形成正类与负类提示语列表。在获得提示语列表后,采用提示集成策略,计算正类提示语和每个同类负类提示语的平均文本特征;进一步将平均文本特征标准化,可获得针对每类动作的最终类别提示语特征。在实际使用过程中,选择CLIP模型认为与图像特征相似度最高的提示语特征所表示的动作类别作为最终的分类结果。提示集成策略在基于单个个体的动作识别任务中可获得良好的效果,如打电话、工作状态识别等场景。总结与展望大模型时代的到来为动作识别提供了新的方法。中国移动信息技术中心积极探索多模态大模型在视频理解领域的应用,将相关能力上架至中国移动能力中台,在阳光评标、智慧乡村、智慧园区等产品项目中落地实践,获得了良好的用户反响。相比OpenPose+规则的动作识别方法,在工作状态识别任务上,多模态大模型可获得超过50%综合准确率提升;在打电话动作识别任务上,多模态大模型可在50%召回率的情况下,提升接近70%的精确度。然而,大模型仍然存在参数量大的局限性,多模态大模型的使用将大大增加模型训练与推理的时间成本,也大大提升部署模型所需要的硬件设备条件,从而限制模型在边缘端设备上的使用。针对上述缺陷,未来中国移动信息技术中心将致力于研发适合于多模态大模型的模型压缩与推理加速技术,进一步推动多模态大模型的落地应用。