通信世界网消息(CWW)大模型对算力的需求呈指数级增长,促使智算业务飞速发展。以生成式预训练(GPT)大模型ChatGPT为例,ChatGPT-6的计算量(Flops)相较于GPT-4提升了1444至1936倍,所使用的图形处理单元(GPU)数量,也从数万个GPU,提高至百万个GPU。

因此,人工智能(AI)下的各类智算应用与业务,要求高速光通信网络具备大带宽、低时延与高可靠等特性以支持算力的发展。同时,也需要高速光通信在组网能力、高速互联、传输时延、可靠传输等方面持续革新。

智算时代的两种集群组网方式

当前,AI智算中心以单点大集群为主,即在同一个物理机房实现模型的训练。而模型规模的扩展、算卡数量提升带来的巨大电力消耗,以及算力碎片化,使得分布式集群成为另一个重要的选择,即利用多个物理机房进行模型训练。此外,目前国产GPU的性能尚与国际先进水平存在一定的差距,因而未来分布式集群更为重要。上述两种不同的集群组网方式,对高速光通信技术提出了差异化的承载需求。

对于单点集群,当前数据中心以Spine-leaf(叶脊)网络架构为主,形成Full-mesh(全互联)拓扑。相较于传统三层网络架构,叶脊网络对光模块的数量需求显著增加,尤其是400G、800G,乃至1.6T这类高速光模块。同时,随着速率的提升,其对光模块封装工艺的要求也不断提高,以降低单比特成本与功耗。此外,全光交换技术在单点集群中可突破电交换在功耗和时延方面的瓶颈,在国外已经开展了商用实践。谷歌公司基于光路交换(OCS)技术构建了Jupiter数据中心网络,英伟达将OCS引入到Spine、Leaf与AI服务器之间,为硬件与软件提供弹性保护。

然而,随着算力需求的高速增长,未来单点集群将面临算力不足的问题,且电力供应也将成为大规模智算建设的瓶颈。例如,OpenAI为训练ChatGPT-6,需要在美国同一个州部署约10万张H100 GPU,每张H100 GPU一年的耗电量约为3.74MW h,而10万张H100 GPU一年的耗电量就达到了惊人37.4万MW h。同时,如何将各类数据中心建设导致的碎片化算力充分利用,也成为一大挑战。此外,受限于当前国产GPU的能力以及GPU生态割裂等问题,国内对多个智算中心间协同计算更加关注,需求也更加迫切。目前业界正在积极探索分布式智算集群应用,并聚焦更长距离、更大带宽与更低时延需求。

对于分布式集群,万卡、十万卡,乃至百万卡级的互联带宽往往达到数十P比特级,甚至超百P比特级。因此,分布式集群间互联带宽需要足够大,以保证算效,并配合带宽收敛技术减少光层的数量来降低成本。当前,业界通过引入波分复用(WDM)技术、提高单波长速率与扩展传输波段,实现带宽增大的目标。例如,谷歌公司目前已完成跨多个数据中心的Gemini Ultra大模型训练,中国电信在其现网中基于波分复用技术完成了业内首例超百千米分布式无损智算网现网验证。同时,也可引入空分复用(SDM)技术,以在物理层面增加传输通道,提高传输带宽。

基于此,本文从单点集群与分布式集群出发,介绍了两种集群方式的关键技术、发展现状与应用实例,并结合中国电信自身的需求,对智算时代的高速光通信技术进行展望。

面向单点集群的数据中心内部(DCN)光通信技术

高速短距光模块

当前,高速光模块电接口单通道100G SerDes(串行器/解串器)速率技术已成熟,配合100G与200G的光口速率,可分别应用于400G与800G短距光模块。对于1.6T的短距光模块,可采用200G SerDes技术,配合200G光口速率实现。目前来看,电接口单通道200G SerDes技术预计于2025年启动研究。高速光模块标准进展情况如表1所示,从标准化角度来看,目前部分标准组织的800G光模块相关标准已基本完成,如IPEC(国际光电委员会)与IEEE(电气电子工程师学会)标准协会等,而1.6T的光模块相关标准正处于研究阶段。

表1高速光模块标准进展情况

高速封装工艺

对于单点集群,能耗与成本一直是关注的焦点。其中,高速光模块的封装技术在近期也呈现多元化演进趋势,尤其是光模块速率的持续提升,对功耗控制、单比特传输成本优化、传输时延降低等方面提出了更高的要求。

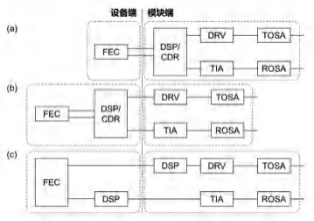

对于400G、800G乃至1.6T光模块而言,线性驱动可插拔光模块(LPO)和线性接收光模块(LRO)成为低功耗与低时延的方案。标准光模块、LPO封装、LRO封装对比如图1所示,标准封装的光模块通常集成了数字信号处理(DSP)芯片,而LPO与LRO光模块则将DSP芯片移至设备侧。其中,LRO光模块仅在发端部署DSP芯片,接收端采用线性接收的方式,虽然这种光模块的封装形态不如LPO降低的功耗与成本多,但与传统包含完全重定时的模块相比有在一定程度的降低。需要指出的是,LPO光模块由于无DSP芯片,在互操作方面仍然存在挑战。目前,业界有11家企业联合成立了LPO-MSA,于2024年第三季度完成LPO系列标准。对于3.2T甚至更高速率的光模块而言,共封装光学(CPO)或为主流封装形态。相较于传统可插拔模块,CPO模块的功耗更低、每路的速率更高、电路衰耗更低,有利于进一步提升带宽,且集成度高,降成本的潜力较大。

图1标准光模块、LPO封装、LRO封装对比

注:中英文对照如下,FEC(前向纠错)、DSP(数字信号处理)、CDR(时钟数据恢复)、

DRV(驱动器)、TIA(跨阻放大器)、TOSA(光发射组件)、ROSA(光接收组件)。

在100G SerDes速率下,LPO与LRO技术可以有效降低成本与功耗,但面向200G SerDes速率下的LPO技术,业界观点仍有一定的分歧。在今年OFC(光纤通信大会)上,业界专家学者展开了激烈的讨论:Macom与Arista对LPO在200G SerDes下的应用持积极态度,而华为、Meta与谷歌等公司考虑到高速SerDes的链路噪声与劣化等,认为LPO在200G SerDes时代应该引入CDR,并采用传统的DSP方案以提高性能。总体来看,LPO与LRO在100G SerDes时代的优势已得到业界的认可,而面向更高速率的DCN互联,还有待进一步探究;而CPO技术因其光电共封装的特性,更加适用于高速互联场景。因此,面向下一代更高速的DCN场景,CPO或将成为一个具备优势的技术方案;而对于可插拔性与模块成本敏感的短距离场景而言,LPO或将成为未来演进趋势。

光路交换(OCS)技术

单点集群的另一个关键技术是OCS,近些年因被谷歌大力推动在数据中心内应用而受到广泛关注。相较于传统的电交换,OCS技术省去了“光-电-光”这一过程,降低了传输的时延与功耗,并具备全光透明的特性。

目前,OCS产品有多种实现方式,主流的如压电陶瓷方案、微电机系统(MEMS)方案以及硅基液晶(LCoS)方案等。压电陶瓷方案采用压电陶瓷材料带动准直器旋转,在空间直接耦合对准(“针尖对麦芒”),实现任意端口光路切换,目前矩阵规模最大可实现576×576,基于压电陶瓷方案的OCS产品具有光开关矩阵规模特别大、插回损超低、切换时间短等特点;MEMS方案采用微型镜片在二维/三维方向转动,对输入信号进行反射,从而实现任意端口光路切换,目前矩阵规模最大可实现320×320,基于MEMS方案的OCS产品具有功耗低、时延低的特点,但切换时间长、校准时间长且成本和插损较高;其他光开关方案诸如硅基液晶方案、液晶光开关、二氧化硅平面光波导(Silica PLC)、热光开关、电光开关等也可实现OCS产品,基于硅基液晶技术的OCS产品可靠性高,切换时间短(200ms以内),但成本较高,而基于其他光开关方案的OCS产品性能仍需进一步验证。

OCS技术在数据中心的典型应用有两种:一种是谷歌将Spine层传统电交换机用OCS代替,另一种是英伟达在Spine、Leaf与AI服务器之间加入OCS。对于前者,谷歌进一步引入了波分复用技术,并在链路中加入了环形器,实现在单根光纤上的速率翻倍;对于后者,OCS技术的引入主要通过控制器构建全新物理拓扑,对硬件故障和软件故障提供弹性修复,并实现物理层设备之间的应用隔离。

总体来说,OCS技术未来将向两个方向发展。一是随着数据中心内部规模的不断增长,时延、功耗等要求会不断提升。OCS因其具有全光交换、光层透明等特征,将向着大端口、低切换时间与低功耗演进,以配合代替Spine层,形成无需“光-电-光”全过程、任意速率/格式/波长的全光交换。同时,继续下沉至Leaf层,需要更低的切换时间、更低的成本与更少的端口数,以提升系统的性能与效果。二是随着数据中心规模的增大,线路的故障率也会有一定的提升,OCS可部署在数据中心多层之间,并通过控制器构建全新的拓扑,以实现物理层设备的应用隔离,提高大规模数据中心的可靠性。

面向分布式集群的数据中心之间光通信技术

大容量波分(WDM)传输技术

分布式集群对带宽(容量)的需求日益增加,尤其是未来万卡,甚至十万卡级别的智算中心间互联。目前通常采用波分复用技术实现传输容量的提升,包括提高单波长速率与扩展传输波段。

对于单波长速率的提升,当前单波长400Gbit/s已开始商用部署,单波长800Gbit/s还处于发展阶段。按照单波长800Gbit/s相干光模块的规格来划分,可分为两种:一种是基于90GBaud左右的短距离800G模块,采用概率成型的双偏振64维正交幅度调制(PS-PM-64QAM),现网一般覆盖数据中心光互联;另一种是基于130GBaud左右的城域800G模块,采用概率成型的双偏振16维正交幅度调制(PS-PM-16QAM)。其中,第二种800G模块可通过配置软件参数,实现覆盖数据中心应用的单波长1.2Tbit/s。

对于传输波段的扩展,当前扩展C波段与扩展L波段技术已经开始商用部署,且传输的波段范围可高达12THz,结合单波长400Gbit/s技术,可实现单根光纤32Tbit/s的容量。面向未来,随着带宽需求的持续提升,S波段将是下一代波段扩展的热点方向。然而,S波段的光纤放大器(如掺铥光纤放大器、TDFA)、收发光器件还处于准备阶段。同时,“C+L+S”波段面临更加严重的受激拉曼散射效应,因此需要进行深度的功率优化,提高多波段的传输性能。此外,系统级的联合优化也是下一代多波段传输的核心难点,包括入纤功率优化与预加载技术的引入,以实现最大的链路吞吐量。

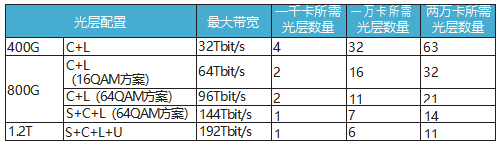

对于未来的分布式集群,考虑智算中心内单算卡的带宽为200Gbit/s,那么一千卡、一万卡与两万卡的互联带宽分别为100Tbit/s、1Pbit/s与2Pbit/s,不同配置下所需的光层数量如表2所示。需要说明的是,这里的千卡互联是指收发两端各500卡,万卡与两万卡同理;分析仅为体现光层配置对光层数量与成本的影响,并未考虑带宽收敛技术,实际上数据中心会采用带宽收敛技术降低成本。在系统配置上,考虑400G采用PM-QPSK调制、800G采用PS-PM-64QAM与PS-PM-16QAM两种调制、1.2T采用PS-PM-64QAM调制,C波段、L波段、S波段与U波段谱宽均为6THz。不难发现,最大带宽越大,所需的光层数量越少。

表2 不同配置下数据中心集群所需的光层数量

现以400G“C+L”与800G“C+L”(16-QAM)方案为例,详细计算两种方案的成本。假设一块400G OTU(光转换单元)的成本为1,一块800G OTU的成本约为1.2,“C+L”的ROADM(可重构光分插复用)、OTM(光终端复用)电子架与光放等其他光层与电层设备成本一致。考虑系统配置为4个跨段、两套OTM与ROADM、三套光放,则一套400G“C+L”与一套800G“C+L”的成本比值约为1﹕1.16。因此,在传输带宽相同的情况下,对于一万卡与两万卡互联,800G“C+L”的成本仅为400G“C+L”的58%与58.9%。由此可见,提高系统最大带宽不仅能有效降低光层数量,还可以进一步降低整个系统的成本。

高速相干光模块技术

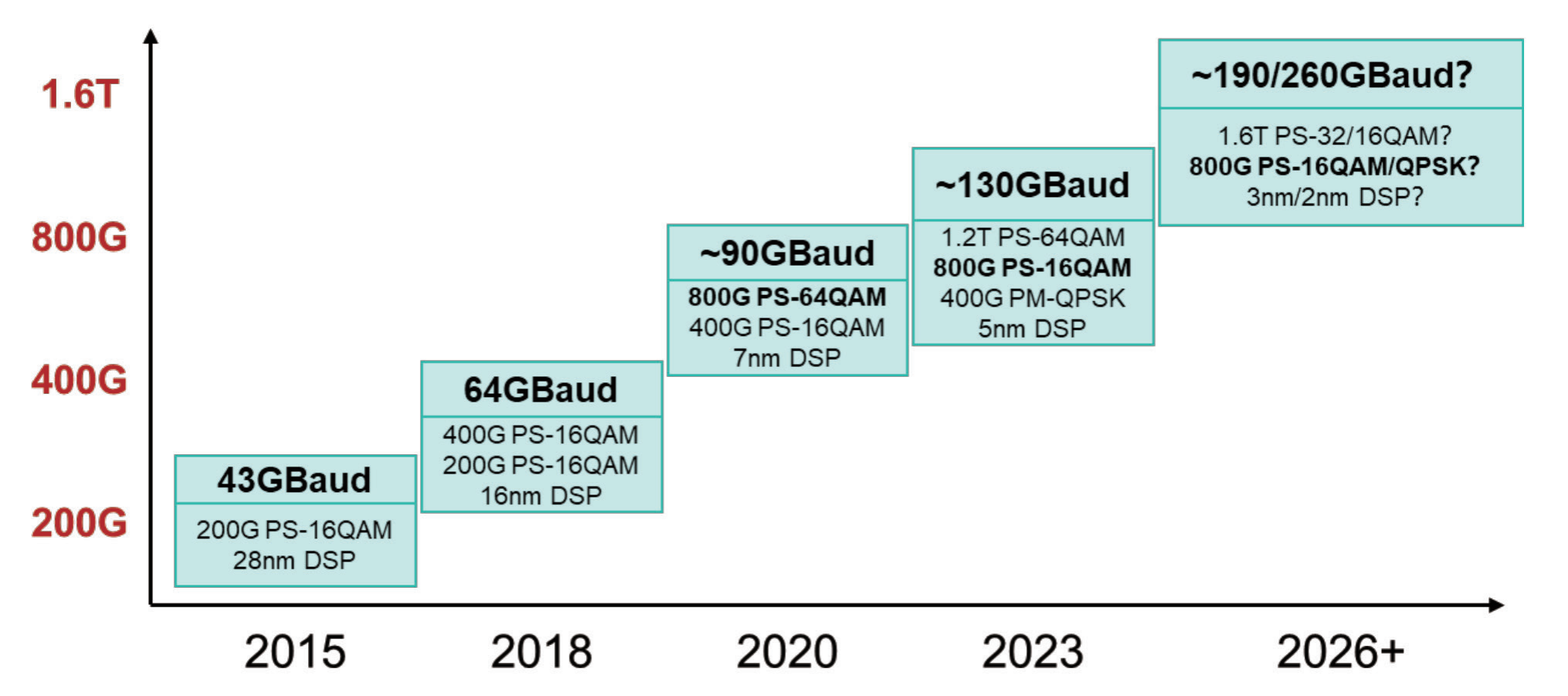

高速光通信系统需要高性能光模块的支持,相干光模块的发展情况如图2所示。当前,相干光模块的波特率已实现130GBaud,正在加速向20 0GBaud演进。对于130GBaud,目前大多数主流厂商均可实现。对于200GBaud,预计基于3nm工艺采用约190GBaud PM-PS-16QAM实现单波长800Gbit/s DSP芯片,有望覆盖城域或长距离应用场景;或者基于2nm工艺采用约240GBaud~270GBaud PM-QPSK实现单波长800Gbit/s DSP芯片,有望覆盖长距离应用场景。

图2 相干光模块的发展情况

目前,800G相干光模块存在可插拔与固定两种形态;1.2T相干光模块仅有固定形态,可插拔产品目前业界没有明确的方向;对于1.6T相干光模块,预计2024年底固定形态产品将发布,可插拔形态产品在2025年或之后发布。

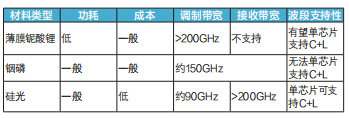

在相干光模块的光芯片材料方面,目前主流的材料有薄膜铌酸锂、铟磷与硅光三种。三种材料因特性的不同,在选择上也有区别,光芯片材料特性对比如表3所示。硅光材料可支持“C+L”波段工作,成本低且集成度高,因而成为目前可插拔模块的主流选择,但面向下一代超200GBaud仍存在技术挑战。因此,应考虑采用具有大带宽优势的薄膜铌酸锂材料,推动长距离骨干网以及超高速传输应用。然而,受限于材料的特性,薄膜铌酸锂仅可用于调制。而铟磷材料的理论调制带宽比硅光更大,模块出光功率也更高,具备更好的传输性能;但其封装较为复杂,且单芯片仅支持单波段工作。总体来说,需综合考虑应用场景、材料特性、成本与集成度等因素,选择合适的技术方案。

表3 相干光模块的光芯片材料特性对比

未来,相干光模块将向着高集成度、小型化、低功耗的方向发展,产业各方需进一步优化材料的性能、模块的设计以及与DSP芯片的适配等。

新型光纤技术

除了通过波分复用技术提高传输带宽外,也可以采用新型光纤技术在物理上提高传输带宽或降低传输时延。其中,以多芯光纤与少模光纤为基础的空分复用技术可以通过增加传输通道的密度,实现传输带宽的翻倍。此外,以空气为介质的空芯光纤具有超低传输时延、超低非线性效应和超低损耗等特性,延迟相对于普通单模光纤可降低约30%;在相同时延下,可实现的最大覆盖范围提升近46%。目前,国际上已研制出最低0.1dB/km衰耗的空芯光纤,并且损耗在持续降低。

2024年,中国电信在杭州智算中心和义桥互联网数据中心之间完成空芯光缆现网部署,标志着空芯光纤具备实际应用的巨大潜力。基于现网部署的20km空芯光纤,实现了100.4Tbit/s的信号实时传输,容量距离积达到了2008Tbit/s·km。在光纤链路方面,实现超10km空芯光纤连续拉丝长度,并在扩展C与扩展L波段上实现最低0.6dB/km的衰减系数。在光纤接续方面,基于梯度放大斜切优化技术,实现单模光纤与空芯光纤单点连接损耗0.25dB、回损小于50dB的高性能连接。在实际部署方面,考虑到空芯光纤的实际结构,中国电信提出了三种防水方案,并解决了无法使用加强芯牵引穿管的问题。最终,在扩展C波段和扩展L波段分别传输41个单波1.2Tbit/s与64个单波800Gbit/s。

未来,应进一步提升空芯光纤制备工艺,降低损耗与成本,并深入研究部署运维方案,如快速便捷熔接、熔接损耗检测、断点检测等,以加速空芯光纤的商用部署。

中国电信面向智算时代的光通信新技术应用探索

400G/800G现网混合速率传输验证

面向城域以及长距离应用场景,中国电信于2024年在长江中下游地区的ROADM网络,开展了业界首个单波长400G/800G混合速率传输系统现网试点,并基于扩展C波段与扩展L波段12THz谱宽,实现了最大传输容量64Tbit/s、最长传输距离超1200km的无电中继传输,证实了混合速率传输的可行性。

目前,400G技术已在现网商用部署,预计其生命周期较长。同时,800G技术也在不断发展之中,针对“长三角”“京津冀”与“粤港澳”等流量需求较大的热点区域,开通800G波长,并与400G骨干网共用光层,进一步降低了建网的成本,仅需在现有的网络上增加800G板卡即可实现。若400G与800G采用相同符号速率,甚至只需要在软件层面修改收发板卡的调制格式等参数,即可实现速率的切换,大大降低了实现难度。

此次400G/800G混合速率现网试点可以加速推进800G商用部署,进一步提高网络吞吐量和利用率,减少设备数量及降低能耗,提升网络资源的利用效率,并可面向热点区域打造差异化服务。

“S+C+L”超120Tbit/s实时传输

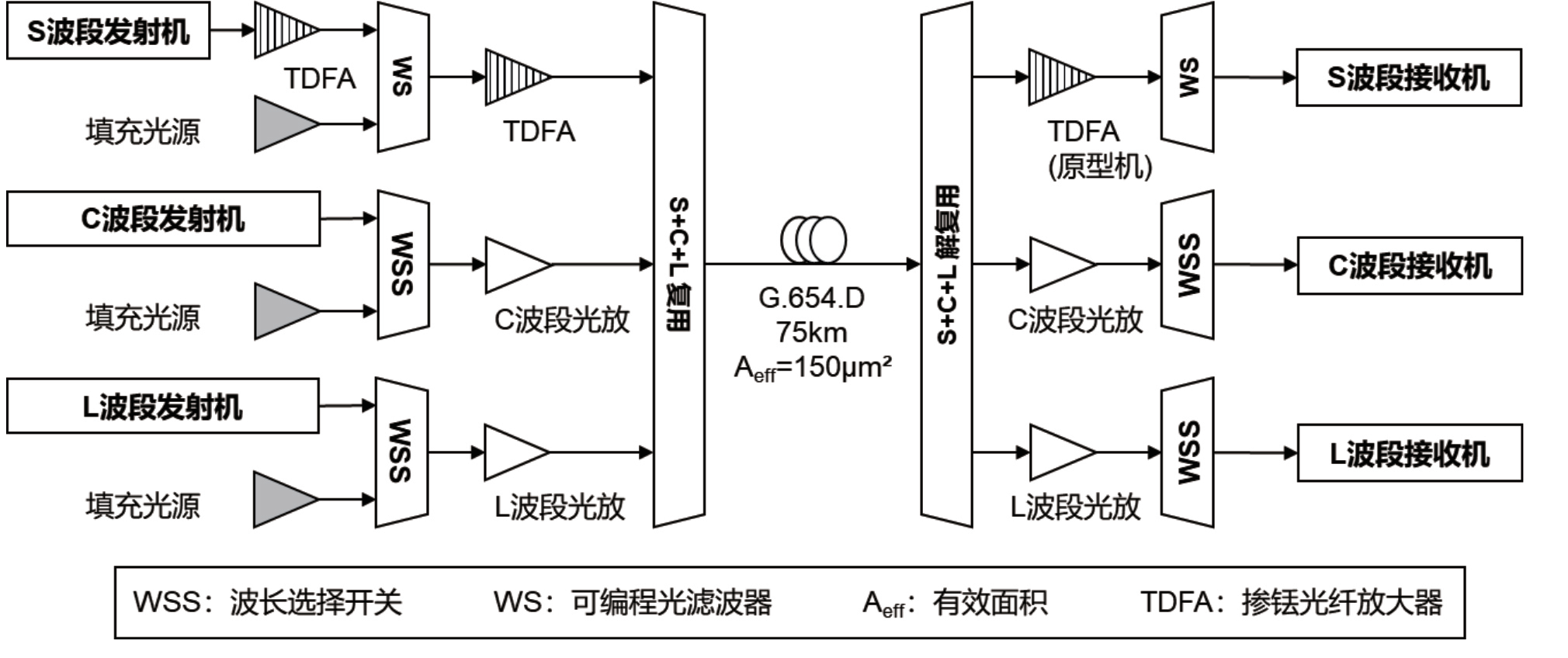

面向短距离智算中心互联场景,2024年中国电信基于“S+C+L”波段实现了单纤超120Tbit/s实时传输纪录,最高的单波长速率可达1.2Tbit/s;S波段谱宽为5THz,C波段与L波段的谱宽均为6THz,系统总谱宽达到了17THz。中国电信“S+C+L”实时超120Tbit/s实验设置如图3所示。

图3 中国电信“S+C+L”实时超120Tbit/s实验设置

实验针对每个波段都采用了差异化的调制格式、符号速率、信道间隔,以最大化系统的频谱效率。此外,针对多波段系统的波长相关损耗与功率转移效应,采用了多波段系统填充波与自动功率均衡技术。对于S波段的信号放大,采用了掺铥光纤放大器,并针对放大器的噪声与增益特性,系统性地调节激光器出光功率等参数,优化链路的光信噪比(OSNR)性能。最终,基于大有效面积(150μm2)的G.654光纤,实现了75km的传输,覆盖数据中心互联应用场景。

总结与展望

智算时代下的高速光通信技术已进入飞速发展阶段,各类新技术的应用正以前所未有的速度改变着时代的进程。一方面,高速光通信技术将贯通智算集群间、智算中心间与智算中心内组网;另一方面,高速光通信技术将渗透进系统内、芯片间与芯片内。

面向单点集群的数据中心内部光通信技术,1.6T超高速光模块配合先进的封装工艺,可实现大带宽、低成本与低功耗的DCN互联;OCS技术的引入,突破传统电交换功耗与时延的瓶颈,为DCN网络架构提供了全新的技术路径。

面向分布式集群的数据中心之间光通信技术,800G/1.2T超高单波速率配合不断扩展的传输波段,可大幅减少DCI互联光层数量并降低成本;空分复用技术的引入在物理层面成倍地提高传输容量;空芯光纤的使用,为DCI提供全新的思路。

面向未来,高速光通信产业各方将不断革新,催生各类颠覆性技术,助力构建数据中心全新网络架构,并在AI时代,为大模型的高效训练提供坚实的承载底座,推动未来产业的创新协同发展。